Dans la longue histoire de l’humanité, on estime à environ 31 000 le nombre de langues qui ont été parlées dans le monde. Aujourd’hui, de toutes ces langues qui ont existé, on n’en parlerait plus que 6 000 et la moitié d’entre elles auraient moins de 10 000 locuteurs.

À voir aussi sur Konbini

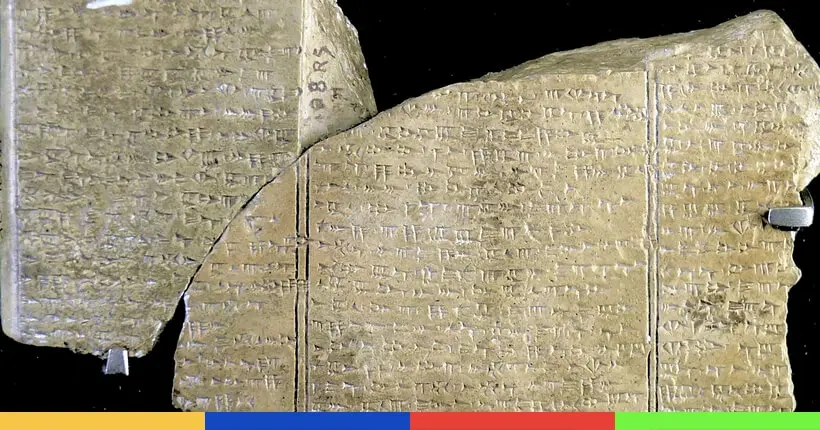

La mort progressive des langues et dialectes est un phénomène qui ne date pas d’hier mais, parmi ces langues “mortes”, des dizaines d’entre elles sont considérées comme des “écritures non déchiffrées”. En plus de ne plus être parlées, ces langues sont littéralement “perdues”, puisqu’il est impossible aujourd’hui d’en comprendre le sens.

Car des écrits retrouvés via des fouilles archéologiques ne possèdent pas de référence linguistique relative qui permettraient une traduction au moins partielle. Pour se faire une idée, certains des dialectes perdus n’ont par exemple ni ponctuation, espace ou même grammaire comparables aux langues connues.

Un article posté sur le blog du MIT fait aujourd’hui part d’une percée scientifique majeure dans le décryptage de ces langues perdues grâce à nouveau système développé par le Computer Science & Artificial Intelligence Lab(CSAIL). Utilisant l’intelligence artificielle, cette technologie permettrait, à terme, de déchiffrer (et non traduire, attention) des langues en réussissant à trouver des relations avec d’autres groupes linguistiques connus.

<em>Découverte en 1799, la pierre de Rosette a permis à Champollion de déchiffrer les hiéroglyphes égyptiens grâce à ses traductions de référence en grec ancien.</em> (© Hans Hillewaert)

Les algos à la rescousse des linguistes

Dirigé par le professeur Regina Barzilay du MIT, le système a déjà permis de trouver des relations (ou non) entre des groupes de langues. Par exemple, il a récemment servi à corroborer les études démontrant que le basque et l’ibérien n’auraient aucun lien de parenté linguistique.

Un “isolat”, une langue dont on n’a retrouvé aucune filiation, ne marque pourtant pas l’arrêt des recherches, car il existe des phénomènes récurrents dans l’évolution globale du langage humain. Par exemple, la transformation de certains sons n’est jamais due au hasard : un “p” dans la langue ascendante a de grandes chances d’évoluer en “b”, mais surement pas en “k”, étant donné la différence de prononciation.

C’est à partir de ces phénomènes plus ou moins constants (et un peu plus complexes que ce grossier exemple) que Barzilay et son étudiant Jiaming Luo ont pu bâtir leurs algorithmes. Ces derniers utilisent le machine learning pour trouver des relations entre les langues. En compilant différentes sonorités et en les mettant en relation avec différents vecteurs de prononciation, la machine calcule et tente de saisir des modèles pertinents d’évolution de langue.

Par apprentissage, l’algorithme va ensuite intégrer ces modèles comme contraintes de calcul pour tenter de déchiffrer des langues mortes. L’algorithme permet également d’évaluer la proximité entre deux langues. Testé sur les langues connues, il est même capable d’identifier chaque famille linguistique avec précision.

Le disque de Phaistos, découvert en Crète, est un bon exemple d’artefact archéologique dont l’écriture et la langue utilisées sont encore un mystère © Wikipedia Commons

Pour le moment, le système est encore très perfectible mais il est en phase de sensiblement accélérer la recherche sur les langues mortes et perdues. Avant cela, Regina Barzilay rappelle, à titre de comparaison, qu’il avait fallu dix ans pour retracer les liens familiaux de la langue “linéaire B”, une forme archaïque du mycénien, sorte de grec ancien.

Les chercheurs ne comptent pas s’arrêter là. Cet algorithme n’en est encore qu’à ses balbutiements et il pourrait à l’avenir être grandement amélioré. Le professeur Barzilay explique par exemple s’attaquer à la dimension sémantique des “mots” analysés, soit leur sens et l’objet de leur présence sur un écrit :

“Nous pouvons identifier toutes les références à des personnes ou des lieux dans un document ; il peut ensuite être mieux étudiée à la lumière de la preuve historique connue […] Ces techniques de ‘ reconnaissance de l’entité’ sont couramment utilisés dans diverses applications de traitement de texte aujourd’hui et sont très précises, mais la question clé de la recherche est de savoir si la tâche est réalisable sans aucune donnée de formation dans la langue ancienne concernée.”

Pour nous écrire : hellokonbinitechno@konbini.com