La photo a connu de nombreuses évolutions, et en voilà une originale. Des chercheur·se·s du MIT ont conçu un réseau neuronal artificiel (une sorte d’algorithme fait pour “penser” comme le cerveau humain) à partir de millions de vidéos YouTube dans lesquelles des personnes parlent. Ce qui est étonnant, c’est que le travail des ingénieur·e·s s’arrête là. Le reste a entièrement été effectué par des ordinateurs. Grâce à ces milliers de vidéos, l’intelligence artificielle a analysé des corrélations entre un visage et une voix.

À voir aussi sur Konbini

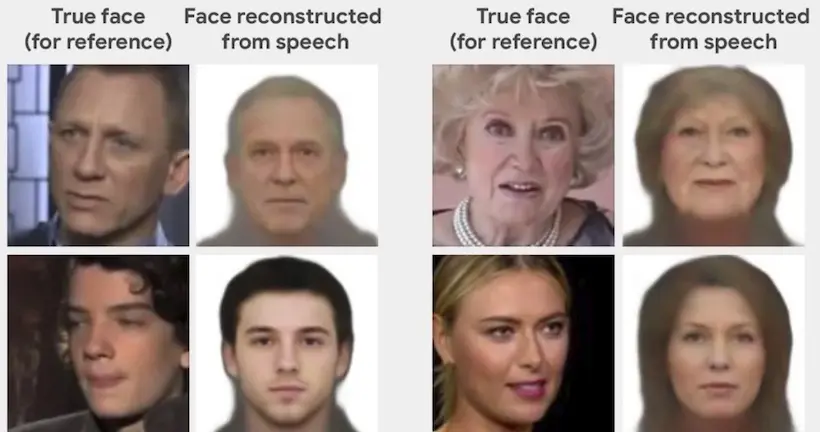

L’IA peut déceler à la voix à qui elle a affaire. Pour cela, Speech2Face se base sur les caractéristiques qui influent sur notre façon de parler, comme le genre, l’âge, la forme de la bouche, la langue, la taille des lèvres, la structure osseuse, l’accent, la vitesse et la prononciation. Les résultats sont impressionnants tant la ressemblance est grande entre le portrait effectué et la personne dont la voix a été analysée.

Une question éthique se pose

Bien que ce système sera sûrement destiné aux forces de l’ordre, l’équipe de chercheur·se·s appelle à la vigilance. Sur le site du projet, les scientifiques admettent que cette technologie pose des questions cruciales en ce qui concerne la discrimination et la vie privée.

Et il y a déjà eu un incident. Nick Sullivan, un ingénieur travaillant pour le compte de la société de sécurité Cloudflare, a été stupéfait en voyant que son visage avait été utilisé pour l’expérience. Pourquoi ne pas avoir demandé l’accord des intéressé·e·s ? C’est la question que Nick Sullivan a souligné : “Étant donné que mon image et ma voix ont été choisies comme exemple dans l’article publié sur Speech2Face, plutôt que d’être simplement utilisées comme point de données dans une étude statistique, il aurait été poli de m’en informer ou de me demander la permission.”

Des biais discriminatoires

Le projet a montré certains aspects très problématiques. L’IA va associer, par exemple, une voix aiguë à une femme et une voix grave à un homme, mégenrant parfois les personnes, ou confondre un accent, une prononciation avec une ethnie. “D’une certaine manière, le système est un peu comme votre oncle raciste”, écrit le photographe Thomas Smith. “Il a l’impression de pouvoir toujours déterminer l’origine ethnique d’une personne en se basant sur la façon dont elle parle – mais il se trompe souvent.”

En clair, si l’habit ne fait pas le moine, la voix ne fait pas le visage, et l’intelligence artificielle, si elle imite parfaitement le cerveau humain en augmentant ses capacités, semble aussi parfaitement reproduire ses préjugés et ses stéréotypes.