Pour ceux qui n’auraient jamais entendu parler ou cerné le concept de big data, don’t panic, ce n’est pas si sorcier : Internet a permis l’émergence et la circulation d’avalanches de données tous secteurs confondus. Ces données ont permis le renouveau récent de l’IA, sous forme de machine learning : les algorithmes engloutissent des millions ou milliards d’infos pour apprendre d’eux-mêmes et faire des prédictions a priori plus fines que celles du cerveau d’un hominidé.

À voir aussi sur Konbini

On n’a jamais (ou presque) entendu parler du petit frère du big data, le small data. Moins hype, moins évident à cerner, moins fascinant, il est pourtant l’objet d’étude d’une start-up française, MyDataModels. À l’occasion du salon Vivatech, dont Konbini est partenaire, nous avons posé quelques questions au CEO, Simon Gazikian. Pour des raisons de clarté, l’interview a été éditée et ne comporte aucune équation mathématique compliquée.

Konbini France | Quel est donc ce small data qui vous intéresse tant ?

Simon Gazikian | Ce sont toutes les données qui sont utilisées dans les “départements” d’une entité (entreprise, administration, etc.) à leur niveau et au quotidien. Généralement, ces départements utilisent Excel et des outils comme Tableau pour analyser leurs données mais ils ne peuvent malheureusement pas, avec ces logiciels, faire de prédictions à partir de ces données.

Pourquoi presque personne ne s’intéresse au small data ?

J’y vois deux raisons : d’une part, les technologies actuelles reposant sur le machine learning ont besoin de beaucoup, beaucoup de données pour fonctionner ; d’autre part, les projets stratégiques sont souvent menés tout en haut des structures, au niveau des directions, qui vont par exemple se demander : “Comment je pourrais accroître les ventes de mon entreprise à partir de tout ce que je sais de mes clients“. On est sur des problématiques de grande échelle.

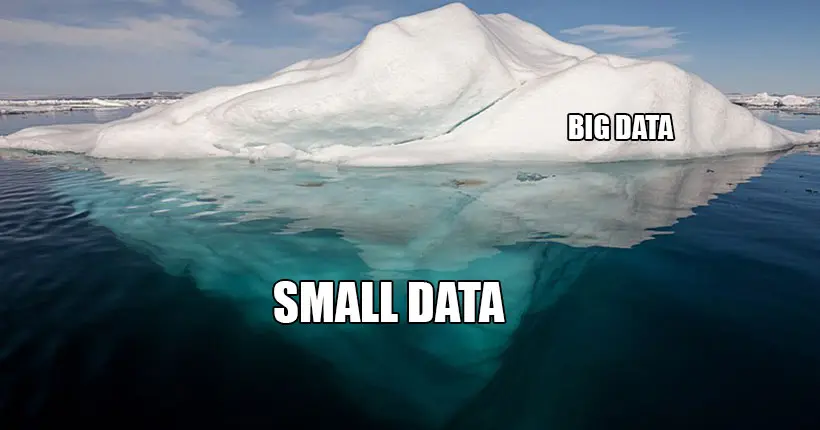

Je fais souvent cette comparaison : ceux qui font du big data font de la haute-couture, nous nous faisons du prêt-à-porter. Et je dis aussi souvent que le small data est la partie immergée de l’iceberg qui représente 85 % de l’ensemble des données récoltées dans les entreprises.

Comment fait-on “parler” le small data ?

Pour simplifier, le big data, ce sont des tableaux avec beaucoup de lignes et beaucoup de colonnes qu’il faut traiter. Dans le small data, ce sont des tableaux avec tout autant de colonnes mais très peu de lignes. Dans le premier cas, et c’est le gros du machine learning aujourd’hui, on va faire appel à des théories issues de la statistique avec, par exemple, des moyennes et des variances.

Notre approche se base sur la technologie des algorithmes dits “évolutifs”, un autre domaine des mathématiques que celui de la statistique. Ces algorithmes ne sont pas nouveaux. Ils ont été créés dans les années 1950 et nous avons éliminé des verrous technologiques majeurs, les rendant aujourd’hui commercialisables

Concrètement, dans quel domaine votre approche pourrait être utile ?

Prenons un domaine dans lequel l’IA est amenée à jouer un rôle important, celui de la santé. Le machine learning utilisant le big data est et va être très utile pour l’interprétation d’images médicales pour prédire, par exemple, des cancers.

Mais il y a des domaines où on ne dispose pas de big data, seulement du small data. Quand des laboratoires veulent analyser l’ADN de cohortes d’individus pour faire des études, mettons, pour analyser leurs génomes afin d’y trouver des gènes responsables de maladies, ils n’ont pas de milliers de cobayes à portée de main, mais seulement quelques dizaines. Dans ce cas-là, notre solution à nous peut réussir là ou les autres ne peuvent pas.

Pourriez-vous aussi analyser quelques images médicales et faire des prédictions ?

Non, pas encore, nous ne travaillons qu’à partir de données tabulaires, sous forme numérique.

Tous les poids lourds de la tech, les GAFAM, sont à fond sur le big data. Vous n’avez pas peur qu’ils viennent vous concurrencer sur votre créneau ?

Peur ? Non. La concurrence, c’est bien, ça amène des solutions et des contre-solutions, et chacun doit trouver de meilleurs arguments. Mais surtout, pour l’instant, faire du small data irait à l’encontre de leurs business models, consistant à vendre énormément de ressources sur le cloud [ndlr : Google, Microsoft ou encore Amazon vendent des services cloud, autrement dit la puissance de calcul de leurs serveurs pour permettre à leurs clients de faire tourner de puissants algos de machine learning]. Pour faire du small data, il faut beaucoup moins de ressources sur le cloud. On peut même le faire en local, sur sa station de travail à soi.

Beaucoup de clients ont-ils succombé aux sirènes du ?

Nous en avons presque une vingtaine. Parmi eux, nous avons Gemalto (entreprise dans la sécurité numérique qui appartient à Thalès) et les labos de l’Inria et de l’Inra. Et très bientôt, nous en aurons une trentaine.