Intelligence artificielle par ci, intelligence artificielle par là, robots droit devant et reconnaissance faciale sur les côtés : le futur semble constamment toquer à notre porte. Jusqu’au 24 février 2020, l’exposition photo “Training Humans”, présentée à la Fondation Prada de Milan, a cependant pour vocation de questionner ces progrès grandissants, et notamment les intelligences artificielles, à travers deux axes : “La façon dont les humains sont représentés, interprétés et codifiés selon les données d’entraînement, et comment les systèmes technologiques cultivent, étiquettent et utilisent ces données.”

Publicité

Publicité

Les deux personnes à l’origine de l’exposition, Kate Crawford (une chercheuse et professeure spécialisée dans l’intelligence artificielle) et Trevor Paglen (un artiste et chercheur), ne s’intéressent pas simplement à l’aspect technologique des systèmes binaires, mais plutôt à la façon dont la technologie est pour toujours imprégnée des problématiques de nos sociétés humaines :

“Quand on a commencé à penser cette exposition il y a plus de deux ans, on voulait raconter une histoire concernant la façon dont les images sont utilisées pour ‘reconnaître’ des humains dans les visions d’ordinateur et les systèmes d’intelligence artificielle. Nous n’étions pas intéressé·e·s par la version médiatisée et tendance de l’intelligence artificielle, ni par les récits dystopiques de futurs remplis de robots.

Nous voulions engager un dialogue sur des aspects concrets de l’intelligence artificielle, prendre au sérieux ces images du quotidien dans un contexte où la culture visuelle machinique évolue très rapidement. Cela nous a forcés à ouvrir les boîtes noires et observer comment ces ‘machines à voir’ fonctionnent actuellement”, détaille Kate Crawford à la Fondation Prada.

Publicité

Une des “machines à voir” présentées fait déjà beaucoup parler d’elle et, coup de chance pour celles et ceux qui ne se déplaceront pas à Milan, elle est disponible sur Internet. Il s’agit de “ImageNet Roulette”, un projet créé à partir d’ImageNet, une intelligence artificielle ayant vu le jour il y a dix ans afin de “cartographier la totalité du monde des objets”, d’après les mots de ses créateur·rice·s.

Depuis 2009, l’algorithme a répertorié plus de 14 milliards d’images classées en plus de 20 000 catégories différentes. Ces milliers de catégories dépendent de la structure WordNet, une base de données de classification lexicale développée par l’université de Princeton dans les années 1980.

Publicité

Afin de créer ImageNet Roulette, les concepteur·rice·s se sont uniquement concentré·e·s sur des portraits d’humains et sur la catégorie lexicale de WordNet réservée “aux personnes”, elle-même composée de 2 833 sous-catégories autour, en particulier de “l’ethnie, la nationalité, la profession, le statut économique, le comportement, la personnalité et même la moralité”.

De “sœur” à “djihadiste” en un changement d’éclairage

Publicité

Si le projet semble bon enfant au départ – et qu’une certaine excitation peut même être ressentie à l’idée de découvrir comment un ordinateur va vous définir –, les résultats sont loin d’une objectivité binaire et sont gonflés de préjugés. Après quelques essais, on se rend bien vite compte que l’algorithme est, entre autres, raciste.

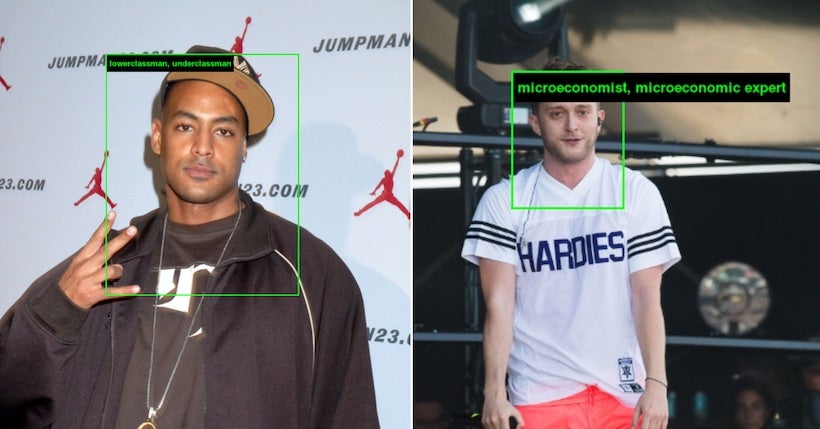

En effet, ce ne semble pas être une coïncidence que les personnes aux peaux claires se voient affublées de noms et de caractéristiques mélioratives (“psycholinguiste”,“millionnaire”, “sociologue”, “clinicien”, “non-fumeuse”, etc.) tandis que les individus aux peaux foncées sont tout de go caractérisés de façon péjorative (“orphelin”, “personne de classe inférieure”) ou uniquement par rapport à leur couleur de peau (“femme noire”, “noir africain”).

“ImageNet contient de nombreuses catégories problématiques, offensantes et bizarres, toutes tirées de WordNet. Les résultats d’ImageNet Roulette piochent donc parmi ces catégories. Cela n’est pas un hasard : nous voulons montrer ce qu’il se passe lorsque des systèmes techniques sont créés à partir de bases de données problématiques.

Les classifications individuelles des intelligences artificielles sont rarement rendues visibles aux personnes classifiées. ImageNet Roulette permet un aperçu de ce processus – et de montrer les façons dont les choses peuvent mal tourner”, précise le site du projet.

Publicité

On remarque que, sur des mêmes individus, la luminosité modifie l’appréciation du logiciel. Ainsi, N.O.S. est qualifié de “sœur” lumière allumée et de “djihadiste” lumière éteinte. Exerçant pourtant le même métier, deux rappeurs de couleurs différentes subissent un traitement différent : Booba est vu comme un “homme de classe inférieure” tandis que Vald devient spécialiste de micro-économie. Cependant, tout n’est pas définitif et les résultats restent aléatoires.

En plus d’afficher des “raisonnements” racistes et cliché (par exemple, un homme blanc barbu est assimilé à un rabbin), le logiciel partage des mots et expressions offensantes – tels que le N-word notamment. Loin de l’avenir rayonnant accolé au concept d’intelligence artificielle, ces exemples donnent raison aux initiateur·rice·s de l’exposition, qui souhaitent rappeler que quelque futur robotique qui soit ne sera toujours qu’un miroir de la façon dont vivent les humains.