D’après Stephen Hawking, l’intelligence artificielle pourrait mettre fin à l’humanité. Nous avons cherché à savoir si cette technologie pouvait réellement nous mettre en danger.

Publicité

Systèmes d’armement, ordinateurs, transports, communications, services à la personne… Dans un avenir de plus en plus proche, l’intelligence artificielle (IA) sera présente au quotidien dans nos vies. Partout sur la planète, des chercheurs travaillent activement à la mise au point et au perfectionnement de machines intelligentes, déjà capables de raisonner et d’agir plus vite que nous.

Publicité

Mercredi 9 mars, soit dix-neuf ans après la victoire aux échecs de l’ordinateur Deep Blue contre Gary Kasparov, la machine de Google AlphaGo l’a emporté face au champion du monde du jeu de go, le Sud-Coréen Lee Se-Dol. Il y a deux ans déjà, Stephen Hawking dressait un portrait sombre de l’avenir, accompagné d’une mise en garde prophétique :

“Je pense que le développement d’une intelligence artificielle complète pourrait mettre fin à l’humanité. Une fois que les hommes l’auraient développée, celle-ci décollerait seule et se redéfinirait de plus en plus vite. Les humains, limités par une lente évolution biologique, ne pourraient pas rivaliser et seraient dépassés.”

Publicité

Pour essayer de savoir si cette menace est réelle ou pas, nous avons convoqué deux supercracks de l’intelligence artificielle : le docteur Yves Demazeau, directeur de recherche au CNRS et président de l’Association française pour l’intelligence artificielle (Afia), et le docteur Henri Prade, également directeur de recherche au CNRS et coauteur de l’étude “Panorama de l’intelligence artificielle”.

Konbini | L’intelligence artificielle est une notion que tout le monde pense connaître. Mais qu’est-ce que c’est exactement ?

Henri Prade | L’intelligence artificielle est née en 1955 aux États-Unis sous l’impulsion de jeunes chercheurs, désireux de faire effectuer à des ordinateurs ce que fait le cerveau humain, en particulier des tâches réputées requérir de l’intelligence. Ces chercheurs avaient des formations en psychologie, en mathématiques, en logique et en électronique.

Publicité

L’intelligence artificielle a un spectre d’intérêts très large. La raison en est simple : le cerveau humain possède de multiples capacités, qui vont des activités réflexes aux activités “réfléchies”. Les recherches en IA tendent à rendre la machine capable d’acquérir de l’information, de raisonner et même de créer.

L’idée serait donc d’arriver à créer une forme d’intelligence qui provienne des machines ?

Yves Demazeau | Oui, mais tout n’est quand même qu’une question d’apparences. Ce qui, au départ, définit très bien l’intelligence artificielle, c’est le test de Turing. Vous mettez une machine et un homme dans deux pièces différentes et vous posez des questions à chacun. Si vous ne savez pas qui de l’homme ou la machine vous répond, alors c’est que le comportement de la machine a atteint le niveau du comportement humain. Mais il ne s’agit pas de dire que la machine est intelligente, elle paraît simplement intelligente. Cela fait une grosse différence.

Publicité

Quel était le but initial de l’IA, créer un cerveau humain artificiel ?

Y.D. | Les recherches en IA sont historiquement liées à la science-fiction, il y avait une sorte de concurrence entre les scientifiques et les écrivains de SF. Un autre vecteur, qui a été très important à l’époque de la Seconde Guerre mondiale, a été le décodage de la machine Enigma, l’instrument de codage des nazis. C’est ce qui a permis de passer de l’informatique traditionnelle à l’IA.

H.P. | Créer un cerveau humain artificiel, non spécialisé, ce n’est pas pour tout de suite. Permettre au cerveau humain de devenir plus puissant est une idée qui n’est apparue que progressivement, avec la capacité des systèmes informatiques de maîtriser des quantités de données et de connaissances toujours plus grandes et d’en tirer l’information immédiatement utile à l’homme.

L’augmentation exponentielle de la puissance des ordinateurs, qui sera décuplée sous peu par les nanotechnologies, peut-elle permettre l’apparition d’une forme de conscience de ces machines ?

Publicité

Y.D. | Pour l’instant, c’est du pur fantasme. Grâce à l’informatique, on peut de nos jours faire de effets spéciaux géniaux dans les films de science-fiction. Mais on est encore très loin du moment où la recherche informatique sera capable de produire des machines qui pourront nous répondre de façon consciente et intelligente !

“À notre stade, la conscience des machines se limite à l’observation extérieure de leur comportement”

Est-ce qu’une masse critique de puissance au sein d’un ordinateur ou d’une machine peut créer de la conscience ?

Y.D. | Je me pose cette question depuis longtemps. Il y a vingt ans, je travaillais avec une centaine de systèmes intelligents. Il y a dix ans, ce chiffre est passé à 10 000. Aujourd’hui, j’ai franchi le cap du million. Quand il y a au moins deux entités, elles peuvent faire plus ensemble qu’en agissant séparément chacune de leur côté.

Si vous rapportez ça à notre cerveau, peut-être que nos capacités intellectuelles naissent de l’interaction entre ces milliards de neurones. À notre stade, la conscience des machines se limite à l’observation extérieure de leur comportement.

À quoi ressemblera notre monde lorsque l’intelligence artificielle aura intégré nos vies ?

Y.D. | Tout va dépendre de ce que l’homme veut que ces machines fassent. Je suis venu à l’IA par la robotique. Au début, la robotique visait à remplacer les ouvriers qui effectuaient des tâches répétitives et pénibles dans les usines. Maintenant, il n’y a plus aucun constructeur automobile qui utilise des peintres dans ses usines, ce sont les robots qui font ça. Toutes ces machines sont aujourd’hui très présentes. La limite de développement se situe au niveau de l’acceptation humaine.

On commence à parler de voitures intelligentes, avec la Google Car notamment. Est-ce que les gens vont accepter facilement de rentrer dans une voiture dont ils ne sont plus les pilotes et confier leurs vies à un système de conduite automatisé ? Tout le monde n’est peut être pas prêt à faire confiance à des machines autonomes. L’acceptation humaine ira toujours moins vite que les progrès technologiques.

Quels sont les risques majeurs liés au développement de l’intelligence artificielle ?

Y.D. | Il y a les mêmes risques que dans tout autre science. Je ne connais pas de chercheur qui ne s’inquiète des détournements possibles de la recherche. C’est notre devoir de nous poser ces questions-là. Maintenant, il n’y a pas plus de risques à développer l’IA que la technologie atomique. Tout dépend de qui s’en servira et comment. Le risque ne vient pas des machines mais des hommes.

En tout cas, permettre au cerveau humain de devenir plus puissant, je n’y crois pas une seconde. Je n’ignore pas les recherches faites dans le domaine de “l’homme augmenté”. Il y a le projet Google X qui cherche à repousser l’âge de la mort à 130 ans pour tout le monde. Mais tout ce côté transhumaniste, ce n’est pas de l’IA.

Créer une intelligence qui finira par nous dépasser semble être assez suicidaire, non ?

H.P. | Pas plus que le développement de beaucoup d’autres technologies qui, selon la manière dont on les emploie, peuvent être bénéfiques ou avoir des effets désastreux. Certes les systèmes d’IA sont capables, dans leurs domaines de spécialisation, de nous dépasser : ils raisonnent plus vite, à partir de plus d’informations, et de manière plus fiable qu’un humain. Le danger, à terme, est que l’humain perde des occasions de faire fonctionner son intelligence, si des systèmes venaient à trop l’assister au quotidien.

“Un neurone, c’est vivant. Ce n’est pas le cas d’un composant en silicium”

Quels sont les obstacles qui restent à franchir pour arriver à créer des machines qui pourront aimer ou pleurer ?

Y.D. : Les émotions permettent de faciliter les interactions avec l’homme. En aucun cas, cela veut dire que le robot a des émotions. Il paraît simplement en avoir. Un robot ne pense pas. Il réfléchit, il raisonne, mais il n’a pas d’âme. Nous avons l’habitude de rire ou de pleurer donc, par extension, on se dit que les machines pourraient le faire ? Mais un neurone c’est vivant. Ce n’est pas le cas d’un composant en silicium.

Il faudrait voir où commence la granularité de l’émotion. Je ne pense pas que l’on arrivera à construire un jour des machines dotées d’émotion. Il y a des différences d’architecture interne trop importantes.

Aujourd’hui, l’IA dépasse-t-elle déjà le cerveau humain ? L’ordinateur Blue Gene est 1,7 fois plus puissant que notre cerveau…

Y.D. : L’IA dépasse très largement le cerveau humain. Aucun être humain n’est capable de faire des calculs aussi complexes que ceux réalisés par l’IA. Ces machines peuvent résoudre des problèmes que l’homme est capable d’exprimer mais elles peuvent aussi résoudre des problèmes qu’il n’est même pas capable de conceptualiser ! Ce n’est pas plus inquiétant que cela tant que ces machines sont entre de bonnes mains.

“Si un robot s’attaque à un humain, c’est qu’il a été programmé pour ça, en principe par un humain d’un camp adverse”

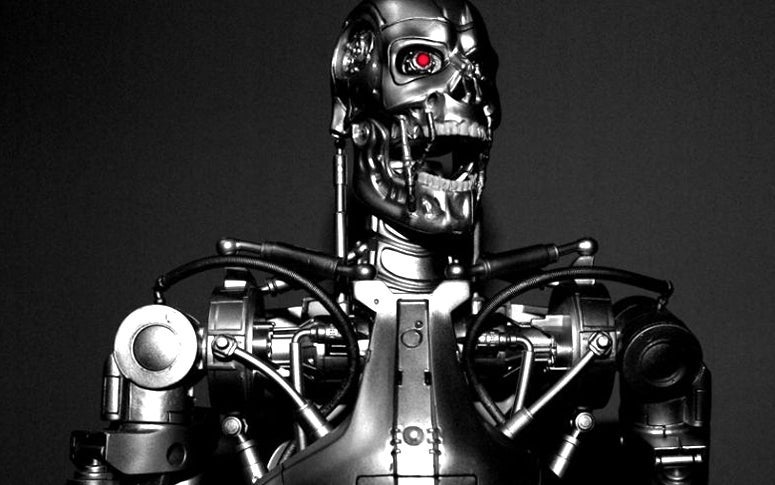

Est-ce que ce que l’on voit au cinéma, avec des robots intelligents bien plus forts que nous et qui cherchent à nous détruire, a des chances de se produire un jour ?

Y.D. : Ce que l’on voit au cinéma, c’est le message que le réalisateur souhaite faire passer. C’est une mise en scène. Dans 2001 : l’odyssée de l’espace par exemple, l’ordinateur est programmé pour se protéger plus que pour veiller sur les habitants de la station orbitale. C’est une question de priorité dans ce qui est programmé dans la machine. Un constructeur pourra décider que la pérennité de la machine passe avant la pérennité de ses utilisateurs. Il faudra voir jusqu’à quel point on souhaite autoriser de telles constructions.

H.P. : On peut rendre des machines capables d’avoir une certaine forme de conscience et même d’autonomie en autoanalysant leurs raisonnements passés et le résultat de leurs actions. Mais si un robot s’attaque à un humain, c’est qu’il a été programmé pour ça, en principe par un humain d’un camp adverse.

Isaac Asimov avait rédigé “les trois lois de la robotique”, des règles qui étaient censées empêcher les robots de se retourner un jour contre nous. Sommes-nous en train de repenser ces règles ?

Y.D. : Ce sont des règles de bonne conduite. Il faut construire des systèmes intelligents dont on pourra être certain qu’ils auront un comportement éthique. Il faudra le même type de normes avant de lancer un produit intelligent que ce qui existe pour les jouets ou les médicaments actuellement, c’est-à-dire des jours et des jours de tests intensifs. Il ne faut jamais oublier que la machine ne pense pas, elle se borne à résoudre un problème. Et comme elle ne pense pas, elle n’est pas capable d’avoir des intentions, malveillantes ou bienveillantes.

“L’intelligence artificielle peut rendre de nombreux services à l’homme mais elle peut aussi le détruire”

Pensez-vous que Stephen Hawking a raison lorsqu’il affirme que l’IA représente une menace mortelle pour l’être humain dans le futur ?

Y.D. : Stephen Hawking, lorsqu’il a tenu ces propos, a été rejoint par plusieurs chercheurs en IA. Ce qui est amusant, c’est que ce sont tout les chercheurs en IA d’un certain âge qui pensent de la sorte. Même si je crois que le risque est bien réel, Hawking mélange un peu tout car il met dans le même panier les recherches sur l’homme augmenté et l’IA. Ce sont deux choses différentes.

De tels systèmes intelligents sont-ils vraiment une menace pour l’être humain ? Tout dépend de qui se servira de cette technologie et dans quel but. L’énergie atomique peut éclairer nos maisons mais aussi détruire la planète. L’intelligence artificielle peut rendre de nombreux services à l’homme mais elle peut aussi le détruire. Le pire danger pour l’homme, c’est l’homme !