Selon une enquête de ProPublica, l’algorithme d’estimation des risques de récidive utilisé par la justice américaine est à la fois inefficace et raciste.

Publicité

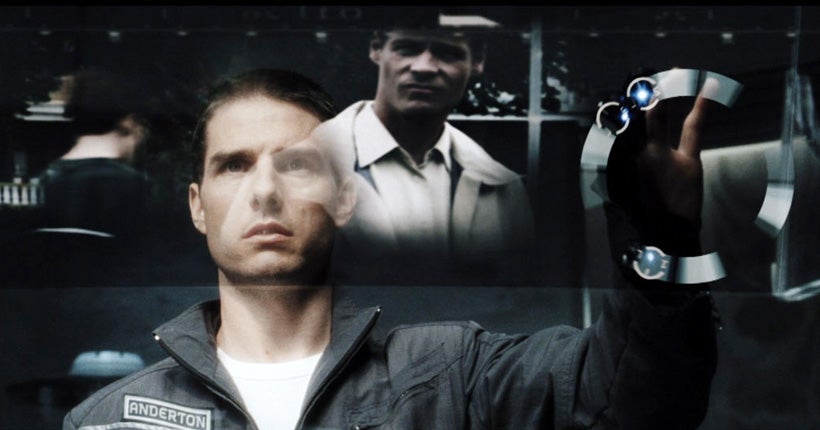

Aux États-Unis, le système judiciaire partage quelques traits de caractère avec son cousin fictif du film Minority Report… Ainsi, à l’échelle locale, de très nombreuses juridictions font appel à des algorithmes d’estimation des risques de récidive. Ces algorithmes prédictifs sont nourris de données, fournies par le détenu, et recrachent une note en fonction du risque de récidive, sur une échelle de un à dix. À un, vous êtes relâché et on vous fout la paix ; à dix, vous sortez accompagné d’un drone de surveillance. En théorie, le dispositif d'”aide à la décision”, censé être parfaitement objectif, peut aider les juges à trancher les cas les plus difficiles. Problème : l’algorithme est peut-être objectif, mais ce sont toujours des êtres humains qui le construisent.

Publicité

Selon une enquête de l’ONG spécialisée dans le journalisme ProPublica, publié le 23 mai, ces algorithmes sont loin d’être aussi objectifs que leur brochure les présente. Dans un long papier baptisé “Machine Bias“, les journalistes ont analysé les résultats du logiciel Compas, manufacturé par l’entreprise Northpointe et utilisé notamment dans le comté de Broward, en Floride. En tout, plus de 10 000 résultats de questionnaires Compas ont été remplis par les détenus lors de leur incarcération et fournis ensuite au logiciel.

En comparant pendant deux ans les scores de récidive attribués par le logiciel aux cas de récidive réellement constatés – la même méthode utilisée par Compas – les journalistes ont pu estimer l’efficacité de l’algorithme. Résultat : “Seuls 20 % des personnes dont le programme estimait qu’elles commettraient un crime violent l’ont commis” et, en incluant les petits délits (jusqu’à la conduite avec permis périmé), ce taux grimpe à 60 %, ce qui est “un peu plus élevé qu’un pile ou face”, explique l’article.

Publicité

Les Noirs ont deux fois plus de risques de récidive que les Blancs

Inefficace, donc, mais aussi biaisé : car en étudiant les données récoltées, les journalistes se sont également rendu compte que le logiciel avait tendance à surévaluer le risque de récidive lorsque les détenus sont afro-américains, environ deux fois plus souvent que les Blancs. L’analyse des condamnations pour récidive prouve également une sous-estimation du risque des détenus blancs.

Après la publication de l’étude, le fabricant du logiciel a bien entendu contesté sa validité, tout en refusant de rendre publique la formule de calcul de son algorithme et les variables sur lesquelles il se base. Tout au plus sait-on qu’il prend en compte le niveau d’étude et la situation professionnelle du sujet (chômeur ou non), et que le questionnaire comprend 137 questions. Qui, si celles-ci vont du casier judiciaire aux fréquentations (“combien de vos amis consomment-ils de la drogue ?”) en passant par des questions d’ordre moral (“selon vous, un homme affamé a-t-il le droit de voler ?”), aucune d’entre elles ne porte sur l’origine ethnique.

Publicité

Des logiciels commercialisés sans garanties d’efficacité

Depuis quelques années, souligne ProPublica, l’usage d’algorithmes prédictifs est de plus en plus adopté dans le paysage judiciaire américain — Compas étant le plus utilisé d’entre eux –, souvent sans attendre les résultats d’études qualitatives. Dans l’État de New York, par exemple, Compas est utilisé depuis 2001. En 2009, cependant, une étude statistique de Tim Brennan, professeur à l’université du Colorado, démontrait un taux d’efficacité du système de 68 %, et une très légère différence de traitement (2 %) entre Noirs et Blancs. En 2011, le même Tim Brennan vendait Northpointe à un conglomérat canadien…

Face à cette prolifération des logiciels prédictifs privés, couplée à une absence quasi totale des retours d’expérience, le ministre américain de la justice Eric Holder avait plaidé pour un ralentissement de leur déploiement et exprimé toute son inquiétude, redoutant que ces dispositifs “puissent augmenter encore des injustices et des inégalités qui existent déjà” dans le système judiciaire. Comme l’expliquait magistralement une enquête publiée en avril 2015 par l’ONG The Marshall Project et le site de data-journalisme FiveThirtyEight, l’avènement de ces algorithmes prédictifs dans l’écosystème judiciaire pose une question avant tout philosophique : les peines de prison, relatives aux offenses commises et au casier judiciaires – le présent et le passé –, doivent-elles désormais prendre en compte une prévision du futur et être décidées en fonction de crimes à venir ? Au vu de l’efficacité des outils de la justice, la question est plus que jamais ouverte.

Publicité